Apple ha defendido sus nuevas herramientas de seguridad para iPhone que se utilizan para detectar contenido de abuso sexual infantil, diciendo que no permitirá que los gobiernos exploten la tecnología para otros fines. Las preocupaciones sobre la privacidad surgieron la semana pasada cuando el gigante tecnológico anunció la medida, que está diseñada para proteger a los jóvenes y limitar la propagación de material de abuso sexual infantil (CSAM).

Entre las características, que se presentarán por primera vez en los EE.UU. a finales de este año, se encuentra la capacidad de detectar imágenes CSAM conocidas almacenadas en iCloud Photos e informarlas a las agencias de aplicación de la ley. La firma ahora ha dejado en claro que si un gobierno solicita usar el mismo sistema para detectar imágenes que no sean CSAM, “rechazará tales demandas”.

“Hemos enfrentado demandas para implementar cambios exigidos por el gobierno que degradan la privacidad de los usuarios y las hemos rechazado firmemente”, dijo Apple.

“Continuaremos rechazándolos en el futuro. Seamos claros: esta tecnología se limita a detectar CSAM almacenado en iCloud y no accederemos a la solicitud de ningún gobierno para expandirla ". Apple dejó las cosas claras en un documento de "preguntas frecuentes" publicado el lunes, destinado a proporcionar "más claridad y transparencia en el proceso".

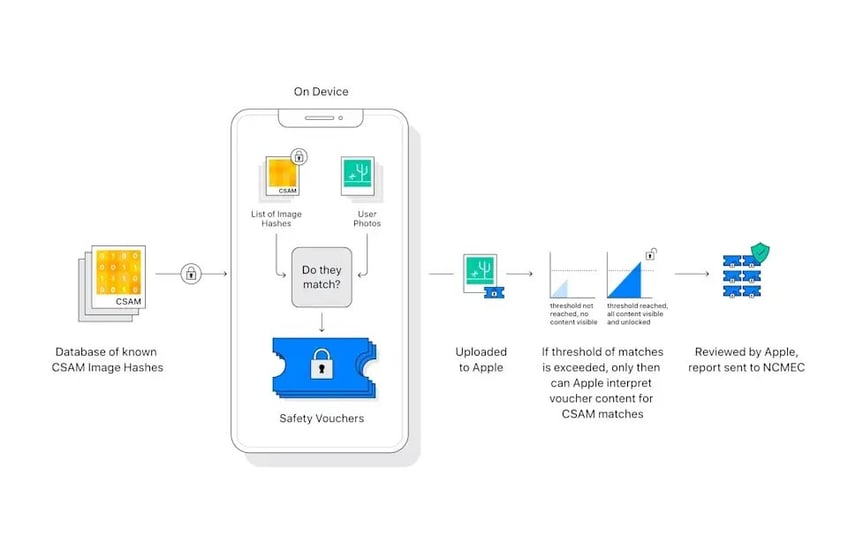

El fabricante del iPhone reiteró que la herramienta no le permite ver o escanear el álbum de fotos de un usuario. En cambio, el sistema buscará coincidencias, de forma segura en el dispositivo, basándose en una base de datos de "hashes", un tipo de huella digital, de imágenes CSAM conocidas proporcionadas por organizaciones de seguridad infantil.

Esta coincidencia solo tendrá lugar cuando un usuario intente cargar una imagen en su biblioteca de fotos de iCloud.

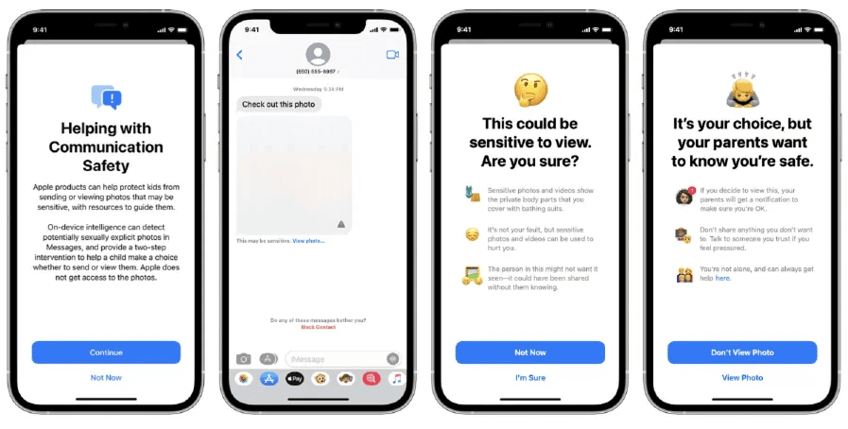

Se unirá a otra característica nueva en la aplicación Mensajes, que advertirá a los niños y sus padres que usan cuentas familiares vinculadas cuando se envían o reciben fotos sexualmente explícitas, con imágenes bloqueadas de la vista y alertas en pantalla; y una nueva guía en Siri y Search que indicará a los usuarios recursos útiles cuando realicen búsquedas relacionadas con CSAM.

Apple dijo que las dos funciones no son iguales y no usan la misma tecnología, y agregó que "nunca" obtendrá acceso a las comunicaciones como resultado de las mejoras en Mensajes.