Una explicación a la polémica decisión de Apple de comenzar a escanear los iPhones en busca de CSAM se ha encontrado en una declaración de 2020 del jefe antifraude de Apple.

Eric Friedman afirmó, con tantas palabras, que "somos la mayor plataforma de distribución de porno infantil." Sin embargo, la revelación plantea la pregunta: ¿Cómo pudo Apple saber esto si no estaba escaneando las cuentas de iCloud...

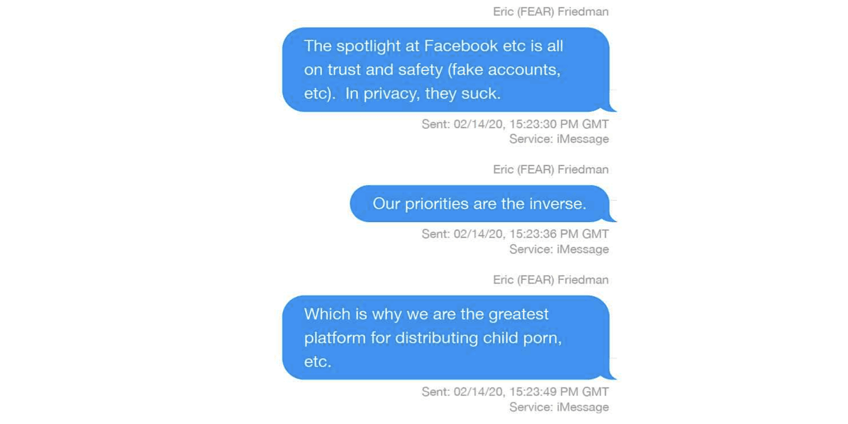

El hilo de iMessage fue descubierto por The Verge mientras se abre camino a través de los correos electrónicos internos, mensajes y otros materiales entregados por Apple como parte del proceso de descubrimiento en la demanda de Epic Games.

De hecho, Friedman sugiere que Facebook hace un mejor trabajo para detectarlo que Apple.

Los focos de atención de Facebook, etc., están puestos en la confianza y la seguridad (cuentas falsas, etc). En privacidad, apestan. Nuestras prioridades son las inversas. Por eso somos la mayor plataforma de distribución de porno infantil, etc..

Un compañero de la ejecutiva cuestiona esto, preguntando si realmente puede ser cierto.

¿De verdad? Quiero decir, ¿hay mucho de esto en nuestro ecosistema? Pensaba que había incluso más oportunidades para los malos actores en otros sistemas de intercambio de archivos.

Friedman responde con la única palabra: "Sí".

El documento está etiquetado, como es lógico, como "altamente confidencial - sólo para los ojos de los abogados".

La sorprendente revelación bien puede explicarse por el hecho de que el almacenamiento de fotos en iCloud está activado por defecto, aunque solo sean los míseros 5 GB que la compañía da a todo el mundo de serie. Esto significa que el servicio puede ser el servicio en la nube más utilizado para las fotos, en contraste con otros de la competencia en los que los usuarios tienen que optar por ello.

Apple ha dicho que ha estado estudiando el problema del CSAM durante algún tiempo, y que estaba tratando de encontrar una forma de protección de la privacidad para detectarlo. Es muy posible que esta conversación específica haya llevado a la compañía a priorizar estos esfuerzos.

Es poco probable que los antecedentes marquen una gran diferencia en la controversia que rodea a la decisión de Apple de llevar a cabo el escaneo de las fotografías de los clientes en los dispositivos, pero al menos proporciona algo de contexto para lo que muchos consideran incoherente con el fuerte mensaje de la compañía sobre la privacidad. Ciertamente, si yo hubiera estado en la posición del CEO Tim Cook cuando se me llamó la atención, querría actuar.

Sin embargo, también plantea la pregunta: ¿Cómo sabía Friedman esto? iMessage está encriptado de extremo a extremo, y Apple dice que no quería escanear iCloud en busca de CSAM. Así que si la compañía no lo hacía, ¿cómo iba a tener conocimiento del alcance del problema en su ecosistema?

Ha habido un aluvión de acontecimientos recientes en la actual saga del CSAM. Gobiernos y organizaciones de derechos civiles han pedido a la empresa que abandone el despliegue previsto. Un desarrollador ha hecho ingeniería inversa del algoritmo central que utiliza Apple, y otro ha conseguido engañarlo. Sin embargo, las salvaguardas que aplica Apple hacen que los riesgos en la vida real de un falso positivo parezcan, por lo que sabemos hasta ahora, muy bajos.

¿Cambia esta revelación tu opinión sobre los planes de escaneo CSAM de Apple? Participa en nuestra encuesta y comparte tu opinión en los comentarios.