La IA ahora se usa para generar pornografía infantil y chantajear a los adolescentes: Experto en seguridad digital

Los delincuentes están proporcionando guías paso a paso sobre cómo crear falsificaciones profundas de niños en la web oscura

Experto en seguridad digital advierte sobre delincuentes que usan inteligencia artificial para crear pornografía infantil

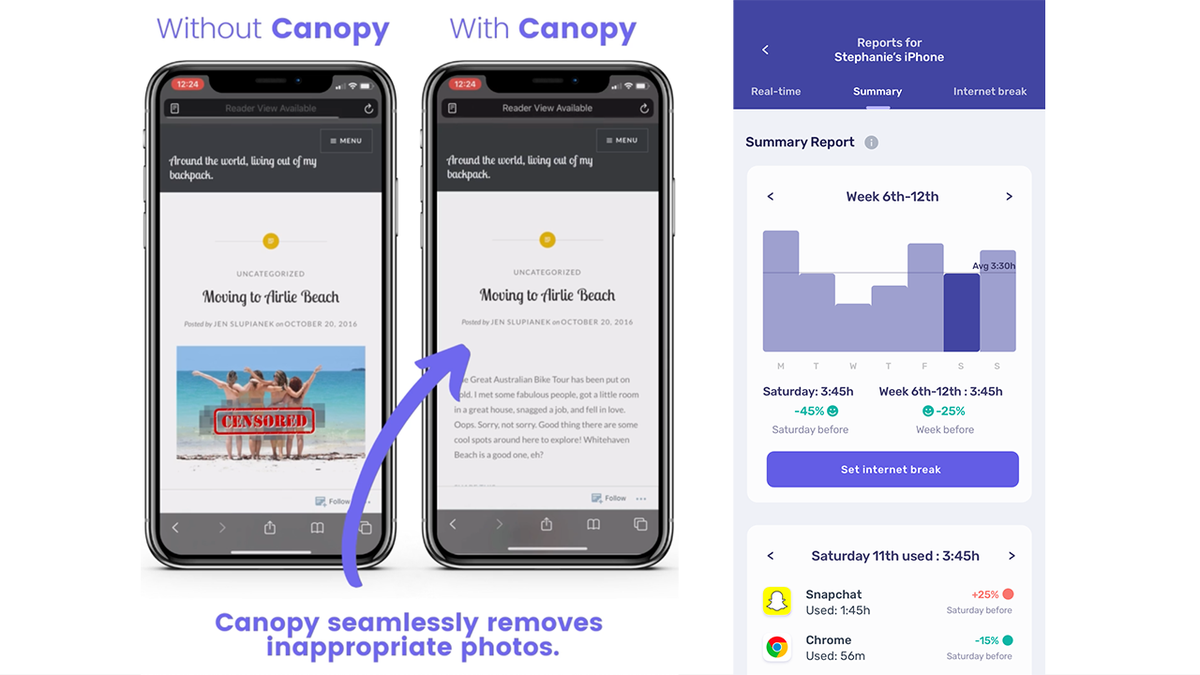

El director de marketing de Canopy, Yaron Litwin, analiza cómo los delincuentes están utilizando la tecnología deepfake para chantajear a los adolescentes y generar pornografía infantil.

El rápido avance de los programas de inteligencia artificial (IA) capaces de generar imágenes realistas ha provocado una explosión de pornografía infantil e intentos de chantaje por parte de delincuentes decididos a explotar a niños y adolescentes.

Yaron Litwin, Director de Marketing y experto en Seguridad Digital de Canopy, una solución líder de inteligencia artificial para combatir el contenido digital dañino, dijo a Fox News Digital que los pedófilos están aprovechando las herramientas en evolución de diversas maneras, a menudo con la intención de producir y distribuir imágenes de explotación sexual infantil en Internet.

Una de estas técnicas consiste en editar una fotografía genuina de un adolescente completamente vestido y convertirla en una imagen desnuda. En un ejemplo del mundo real ofrecido por Litwin, un niño de 15 años interesado en el estado físico personal se unió a una red en línea de entusiastas del gimnasio. Un día, compartió una foto que incluía su pecho desnudo después de un entrenamiento con el grupo. Esa imagen fue tomada, editada en una imagen desnuda y utilizada para chantajear al adolescente, quien inicialmente pensó que su foto era inofensiva y segura en manos de otros asistentes al gimnasio.

En 2022, los principales sitios de redes sociales reportó un aumento del 9% en materiales sospechosos de abuso sexual infantil en sus plataformas. Instagram Facebookel 85% de esos informes provino de plataformas Meta digitales como Facebook, Instagram y WhatsApp.

La jefa de seguridad de Meta, Antigone Davis, declaró anteriormente que el 98% del contenido peligroso se elimina antes de que alguien lo informe a su equipo y que la compañía informa más materiales de abuso sexual infantil (CSAM) que cualquier otro servicio.

Litwin dijo que el proceso de edición de imágenes existentes con IA se ha vuelto increíblemente fácil y rápido, lo que a menudo conduce a experiencias horribles para las familias. Esa facilidad de uso también se transfiere a la creación de imágenes completamente fabricadas de explotación sexual infantil, que no dependen de imágenes auténticas.

"Estos no son niños de verdad", dijo Litwin. "Estos son niños que se están generando a través de la IA y, a medida que esta IA, a medida que el algoritmo recibe más de estas imágenes, básicamente puede mejorarse a sí mismo, de manera negativa."

Según un análisis reciente, Las imágenes generadas por IA de niños involucrados en actos sexuales podrían interrumpir el sistema de seguimiento central que bloquea CSAM de la web. En su forma actual, el sistema solo está diseñado para detectar imágenes conocidas de abuso en lugar de las generadas. Esta nueva variable podría llevar a las fuerzas del orden a dedicar más tiempo a determinar si una imagen es real o generada por IA.

Litwin dijo que estas imágenes también plantean preguntas únicas sobre qué viola las leyes estatales y federales de protección infantil y pornografía. Si bien los agentes del orden y los funcionarios del Departamento de Justicia afirman que dichos materiales son ilegales incluso si el niño en cuestión es generado por IA, ningún caso de este tipo ha sido juzgado en los tribunales.

Además, argumentos legales pasados indican que dicho contenido podría ser un área gris en la ley estadounidense. Por ejemplo, la Corte Suprema derogó varias disposiciones que prohibían la pornografía infantil virtual en 2002, argumentando que el fallo era demasiado amplio e incluso podría abarcar y criminalizar las representaciones de la sexualidad adolescente en la literatura popular.

En ese momento, el Presidente del Tribunal Supremo William H. hizo una ominosa disidencia que predijo muchas de las preocupaciones éticas de la nueva revolución de la IA.

"El Congreso tiene un interés apremiante en garantizar la capacidad de hacer cumplir las prohibiciones de la pornografía infantil real, y deberíamos remitirnos a sus hallazgos de que el rápido avance de la tecnología pronto hará que sea casi imposible hacerlo", dijo.

Una variedad de otros factores han exacerbado las preocupaciones sobre la explotación sexual infantil en línea. Aunque generativo Las herramientas de IA han sido enormemente beneficiosas en la creación de nuevas fotografías, obras de arte y novelas ilustradas, los pedófilos ahora están utilizando navegadores especiales para interactuar con foros y compartir guías paso a paso sobre cómo crear nuevos materiales ilícitos con facilidad. Estas imágenes luego se comparten o se usan para cultivar una personalidad falsa en línea para conversar con los niños y ganarse su confianza.

Aunque la mayoría de los programas de IA, como Stable Diffusion, Midjourney y DALL-E tienen restricciones sobre las indicaciones a las que responderá el sistema, Litwin dijo que los delincuentes están comenzando a aprovechar los algoritmos de código abierto disponibles en la dark web. En algunos casos, los programas de IA de fácil acceso también pueden ser engañados, utilizando palabras y asociaciones específicas para eludir las barandas establecidas y responder a indicaciones potencialmente nefastas.

Según Litwin, debido a la gran abundancia de material explícito generado, estas imágenes son difíciles de bloquear y filtrar, lo que facilita atraer a los niños y exponerlos a contenido dañino.

"Si no estuviera en esta industria, no lo sé, como padre, si estaría completamente consciente de a dónde podría ir esto y qué se podría hacer", agregó Litwin.

Sin embargo, señaló que mientras La IA puede dañar potencialmente a los niños, Canopy fue desarrollado, a través de 14 años de entrenamiento en algoritmos de IA, para ser un ejemplo de " IA para siempre."

Canopy es una aplicación digital para padres que detecta y bloquea contenido inapropiado en milisegundos antes de que llegue a la computadora o pantalla del teléfono de un niño.

"Mientras navegas por Internet, mientras buscas en las redes sociales, si apareciera una imagen, la filtraría. La mayoría de los productos que existen simplemente bloquearán todo el sitio web. Una vez que identifica una imagen potencial. De hecho, podemos filtrarlo todo para que aún pueda navegar", dijo Litwin.

La solución utiliza tecnología informática avanzada, incluida la inteligencia artificial y el aprendizaje automático, para reconocer y filtrar contenido inapropiado en la web y las aplicaciones populares de redes sociales.

Además del Filtro inteligente, que detecta y bloquea imágenes y videos inapropiados, Canopy proporciona alertas de sexting que pueden ayudar a detectar y evitar que se compartan fotos inapropiadas.

"[Un niño] podría pensar que un niño de su edad está en el otro extremo cuando en realidad no lo está. Entonces, podemos poner esa barrera entre quizás una mala decisión y dejar que los padres decidan, ya sabes, si quieren permitir eso o no", dijo Litwin.

La solución también incluye Prevención de eliminación, lo que garantiza que Canopy no se pueda eliminar o deshabilitar sin el permiso de un padre o tutor.

Nikolas Lanum es editor de video para Fox News Digital.