Apple heeft zijn nieuwe veiligheidstools voor iPhone, die worden gebruikt om inhoud met seksueel misbruik van kinderen op te sporen, verdedigd door te zeggen dat het niet zal toestaan dat de technologie door regeringen voor andere doeleinden wordt misbruikt. Vorige week werd bezorgdheid over de privacy geuit toen de techgigant de maatregel aankondigde, die bedoeld is om jongeren te beschermen en de verspreiding van materiaal over seksueel misbruik van kinderen (CSAM) te beperken.

Een van de voorzieningen - die later dit jaar als eerste in de VS worden geïntroduceerd - is de mogelijkheid om in iCloud Foto's opgeslagen CSAM-beelden op te sporen en te melden bij wetshandhavingsinstanties. Het bedrijf heeft nu duidelijk gemaakt dat als een overheid vraagt om hetzelfde systeem te gebruiken voor het detecteren van niet-CSAM-afbeeldingen, het "dergelijke verzoeken zal weigeren".

"We hebben te maken gehad met eisen om door de overheid opgelegde wijzigingen te bouwen en in te voeren die de privacy van gebruikers aantasten, en hebben die eisen standvastig geweigerd", aldus Apple.

"We zullen ze ook in de toekomst blijven weigeren. Laten we duidelijk zijn: deze technologie is beperkt tot het detecteren van CSAM dat is opgeslagen in iCloud en we zullen niet ingaan op het verzoek van welke overheid dan ook om dit uit te breiden." Apple zette de zaken recht in een "veelgestelde vragen" document dat op maandag werd vrijgegeven, bedoeld om "meer duidelijkheid en transparantie in het proces" te bieden.

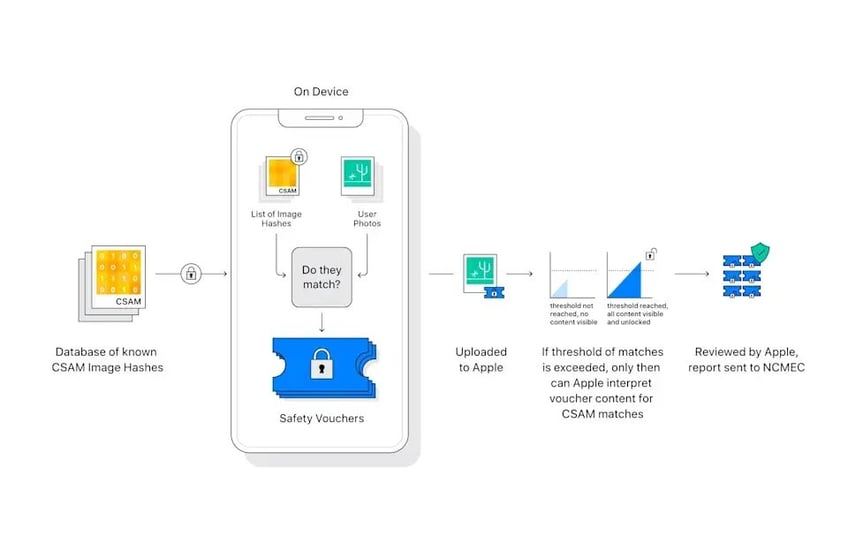

De iPhone-maker herhaalde dat de tool het niet mogelijk maakt om het fotoalbum van een gebruiker in te zien of te scannen. In plaats daarvan zoekt het systeem, veilig op het toestel, naar overeenkomsten op basis van een database van "hashes" - een soort digitale vingerafdruk - van bekende CSAM-beelden die door kinderveiligheidsorganisaties zijn verstrekt.

Deze vergelijking vindt alleen plaats wanneer een gebruiker een foto probeert te uploaden naar zijn iCloud-fotobibliotheek.

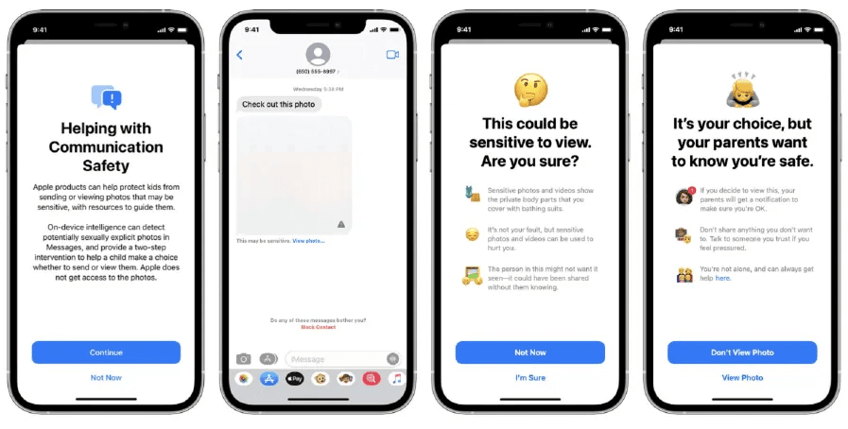

Daarnaast komt er een nieuwe functie in de Berichten-app, die kinderen en hun ouders met gekoppelde gezinsaccounts waarschuwt als er seksueel expliciete foto's worden verzonden of ontvangen, met geblokkeerde beelden en waarschuwingen op het scherm; en nieuwe aanwijzingen in Siri en Search, die gebruikers naar nuttige informatiebronnen verwijzen als ze zoekopdrachten geven die met CSAM te maken hebben.

Apple zei dat de twee functies niet hetzelfde zijn en niet dezelfde technologie gebruiken, en voegde eraan toe dat het "nooit" toegang zal krijgen tot communicatie als gevolg van de verbeteringen in Berichten.