Ambtenaren van de kinderbescherming in Oregon zullen stoppen met het gebruik van een algoritme om te helpen beslissen welke gezinnen worden onderzocht door maatschappelijk werkers, en kiezen in plaats daarvan voor een nieuw proces waarvan ambtenaren zeggen dat het betere, meer raciaal rechtvaardige beslissingen zal maken.

Deze maatregel komt enkele weken na een onderzoek door Associated Press van een afzonderlijk algoritmisch instrument in Pennsylvania dat de ambtenaren van Oregon oorspronkelijk had geïnspireerd om hun model te ontwikkelen, en waarvan werd vastgesteld dat het een onevenredig aantal zwarte kinderen had aangemerkt voor "verplicht" verwaarlozingsonderzoek toen het voor het eerst werd toegepast.

Oregon's Department of Human Services kondigde vorige maand per e-mail aan het personeel aan dat na een "uitgebreide analyse" de hotline-medewerkers van het bureau eind juni zouden stoppen met het gebruik van het algoritme om ongelijkheden te verminderen met betrekking tot welke gezinnen worden onderzocht op kindermishandeling en verwaarlozing door kinderbeschermingsdiensten.

"We zijn toegewijd aan voortdurende kwaliteitsverbetering en gelijkheid," zei Lacey Andresen, de adjunct-directeur van het agentschap, in de e-mail van 19 mei.

Jake Sunderland, een woordvoerder van het departement, zei dat het bestaande algoritme "niet langer nodig is," omdat het niet kan worden gebruikt met het nieuwe screeningproces van de staat. Hij weigerde verdere details te geven over waarom Oregon heeft besloten het algoritme te vervangen en wilde niet ingaan op eventuele ongelijkheden die van invloed zijn geweest op de beleidswijziging.

De beslissingen van hotline-medewerkers over meldingen van kindermishandeling en verwaarlozing vormen een kritiek moment in het onderzoeksproces, wanneer maatschappelijk werkers voor het eerst beslissen of gezinnen door de staat moeten worden geholpen. Er staat veel op het spel - niet ingaan op een beschuldiging kan de dood van een kind tot gevolg hebben, maar het leven van een gezin onder de loep nemen kan het gezin in een scheiding storten.

Van Californië tot Colorado en Pennsylvania, waar kinderwelzijnsorganisaties algoritmen gebruiken of overwegen te implementeren, heeft een AP-onderzoek bezorgdheid geuit over transparantie, betrouwbaarheid en raciale ongelijkheden in het gebruik van de technologie, inclusief hun potentieel om vooroordelen in het kinderwelzijnssysteem te verharden.

Senator Ron Wyden, een Democraat uit Oregon, zei dat hij al lang bezorgd was over de algoritmen die worden gebruikt door het kinderwelzijnssysteem van zijn staat en dat hij na het AP-verhaal opnieuw contact opnam met de afdeling om vragen te stellen over raciale vooroordelen - een heersend punt van zorg bij het groeiende gebruik van kunstmatige intelligentie-instrumenten in kinderbeschermingsdiensten.

"Beslissingen nemen over wat er met kinderen en gezinnen moet gebeuren is een veel te belangrijke taak om ongeteste algoritmen te geven," zei Wyden in een verklaring. "Ik ben blij dat het Oregon Department of Human Services de zorgen die ik heb geuit over raciale vooroordelen serieus neemt en het gebruik van zijn screening tool pauzeert."

Sunderland zei dat Oregon kinderwelzijn ambtenaren al lang overwogen om hun onderzoeksproces te veranderen voordat ze vorige maand de aankondiging deden.

Hij voegde eraan toe dat de staat onlangs besloot dat het algoritme volledig zou worden vervangen door zijn nieuwe programma, genaamd het Structured Decision Making-model, dat aansluit bij veel andere kinderwelzijnsjurisdicties in het hele land.

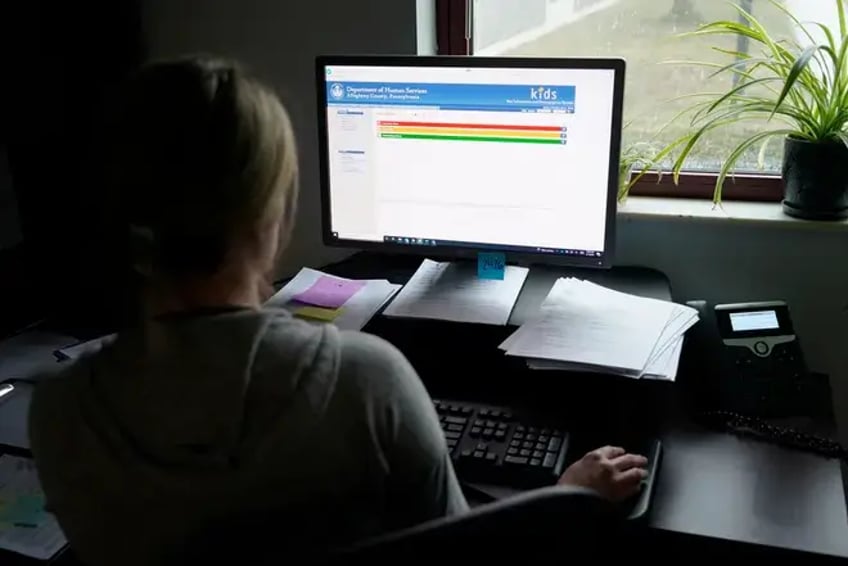

Oregon's Safety at Screening Tool werd geïnspireerd door het invloedrijke Allegheny Family Screening Tool, dat is vernoemd naar de county rond Pittsburgh, en is gericht op het voorspellen van het risico dat kinderen lopen om in de toekomst in pleegzorg terecht te komen of te worden onderzocht. Het werd voor het eerst toegepast in 2018. Maatschappelijk werkers bekijken de numerieke risicoscores die het algoritme genereert - hoe hoger het getal, hoe groter het risico - wanneer ze beslissen of een andere maatschappelijk werker het gezin moet gaan onderzoeken.

Maar ambtenaren van Oregon hebben hun oorspronkelijke algoritme aangepast om alleen gebruik te maken van interne kinderwelzijnsgegevens bij het berekenen van het risico van een gezin, en hebben geprobeerd om bewust raciale vooroordelen in het ontwerp aan te pakken met een "billijkheidscorrectie".

Als reactie op de bevindingen van onderzoekers van de Carnegie Mellon University dat het algoritme van Allegheny County aanvankelijk een onevenredig aantal zwarte gezinnen aanmerkte voor "verplicht" onderzoek naar verwaarlozing van kinderen, noemden ambtenaren van de county het onderzoek "hypothetisch" en merkten op dat maatschappelijk werkers het instrument altijd kunnen opheffen, omdat het nooit bedoeld was om alleen te worden gebruikt.

Wyden is een van de hoofdsponsors van een wetsvoorstel dat transparantie en nationaal toezicht op software, algoritmen en andere geautomatiseerde systemen beoogt.

"Nu de bestaansmiddelen en de veiligheid van kinderen en gezinnen op het spel staan, moet de door de staat gebruikte technologie rechtvaardig zijn - en ik zal blijven waken," zei Wyden.

Het tweede instrument dat Oregon ontwikkelde - een algoritme om te helpen beslissen wanneer pleegkinderen kunnen worden herenigd met hun families - blijft opgeschort terwijl onderzoekers het model herwerken. Sunderland zei dat het experiment maanden geleden werd gepauzeerd wegens onvoldoende gegevens, maar dat er "geen verwachting is dat het binnenkort zal worden onderbroken".

In de afgelopen jaren, toen het onder de loep werd genomen door een raad voor crisistoezicht op bevel van de gouverneur, overwoog het staatsagentschap - dat zich momenteel opmaakt om zijn achtste nieuwe directeur voor kinderwelzijn in zes jaar aan te nemen - drie extra algoritmen, waaronder voorspellende modellen die probeerden het risico van een kind op overlijden en ernstig letsel te beoordelen, of kinderen in pleegzorg moeten worden geplaatst, en zo ja, waar. Sunderland zei dat de kinderbescherming deze instrumenten echter nooit heeft gebouwd.