Een verklaring voor het omstreden besluit van Apple om iPhones te gaan scannen op CSAM is te vinden in een verklaring uit 2020 van Apple's chef fraudebestrijding.

Een verklaring voor Apple's omstreden besluit om iPhones te gaan scannen op CSAM is gevonden in een verklaring uit 2020 van Apple's chef fraudebestrijding.

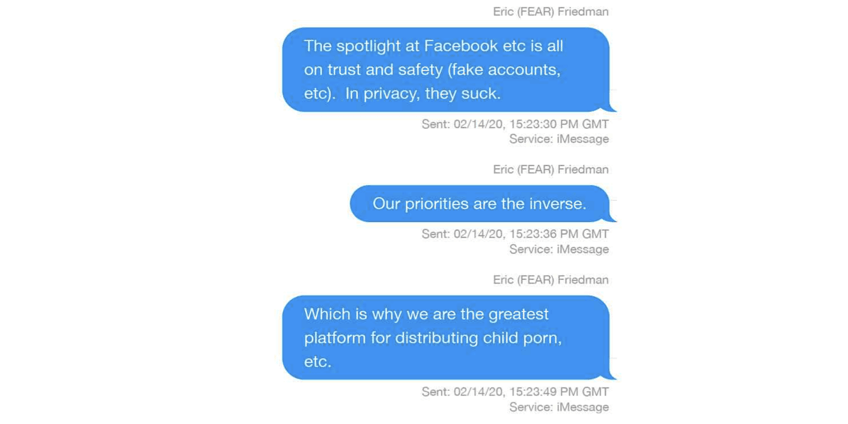

Eric Friedman verklaarde met zoveel woorden dat "wij het grootste platform zijn voor het verspreiden van kinderporno." De onthulling roept wel de vraag op: Hoe had Apple dit kunnen weten als het iCloud-accounts niet scande... ?

De iMessage thread werd gespot door de Verge, die zich een weg baant door de interne e-mails, berichten en ander materiaal dat Apple heeft overhandigd als onderdeel van het ontdekkingsproces in de rechtszaak tegen Epic Games.

Ironisch genoeg suggereert Friedman eigenlijk dat Facebook het beter kan opsporen dan Apple deed.

De schijnwerpers bij Facebook etc. staan allemaal op vertrouwen en veiligheid (nepaccounts, etc). In privacy, ze zuigen. Onze prioriteiten zijn omgekeerd. Daarom zijn wij het grootste platform voor de verspreiding van kinderporno, enz.

Een collega vraagt zich af of dit echt waar kan zijn.

Echt waar? Ik bedoel, is er veel van dit in ons ecosysteem? Ik dacht dat er nog meer mogelijkheden waren voor slechte actoren op andere filesharing systemen.

Friedman antwoordt met het enkele woord: "Ja."

Het document is niet verrassend voorzien van het label "Zeer vertrouwelijk - alleen voor advocaten."

De verbijsterende onthulling is wellicht te verklaren door het feit dat iCloud-foto-opslag standaard aan staat, ook al is het maar de schamele 5 GB die het bedrijf iedereen standaard geeft. Dit betekent dat de dienst misschien wel de meest gebruikte cloudservice voor foto's is - in tegenstelling tot concurrerende diensten waarvoor gebruikers moeten kiezen.

Apple heeft gezegd dat het al een tijdje naar het CSAM-probleem kijkt en een privacybeschermende manier probeert te vinden om het op te sporen. Het is heel goed mogelijk dat dit specifieke gesprek ertoe heeft geleid dat het bedrijf prioriteit heeft gegeven aan deze inspanningen.

De achtergrond zal waarschijnlijk niet veel verschil maken in de controverse rond het besluit van Apple om foto's van klanten op het apparaat te scannen, maar het biedt in ieder geval enige context voor wat velen beschouwen als inconsistent met de sterke boodschap van het bedrijf over privacy. Als ik in de positie van CEO Tim Cook had verkeerd toen dit onder mijn aandacht werd gebracht, zou ik zeker actie willen ondernemen.

Het roept echter ook de vraag op: Hoe wist Friedman dit? iMessage is end-to-end versleuteld, en Apple zegt dat het iCloud niet wilde scannen op CSAM. Dus als het bedrijf dit niet deed, hoe kon het dan op de hoogte zijn van de omvang van het probleem in zijn ecosysteem? Er is een golf van recente ontwikkelingen geweest in de voortdurende CSAM-saga. Regeringen en burgerrechtenorganisaties hebben het bedrijf opgeroepen om af te zien van de geplande uitrol. Een ontwikkelaar heeft het kernalgoritme dat Apple gebruikt ontraadseld, en een andere is erin geslaagd het te manipuleren. De veiligheidsmaatregelen die Apple toepast, zorgen er echter voor dat het risico op een vals-positieve test in de praktijk erg klein is, op basis van wat we tot nu toe weten.

Verandert deze onthulling uw mening over Apple's CSAM-scanningplannen? Doe mee aan onze poll, en deel uw mening in de comments.